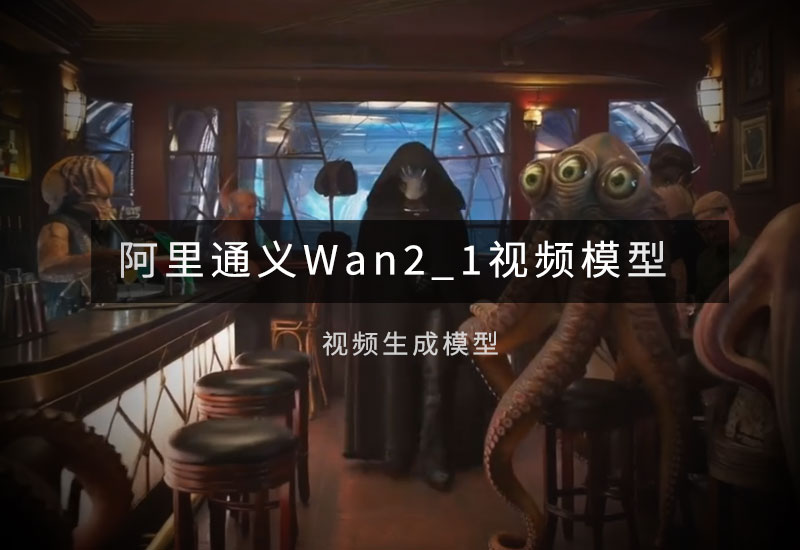

工作流介绍

该工作流是基于 Wan-AI/Wan2.2-I2V-A14B的量化GGUF模型以及MOE自动切换采样器,通过输入一张首帧图,控制ComfyUI生成视频,并且融入Lightx2v加速LoRA,在质量和速度上相对平衡。

环境配置

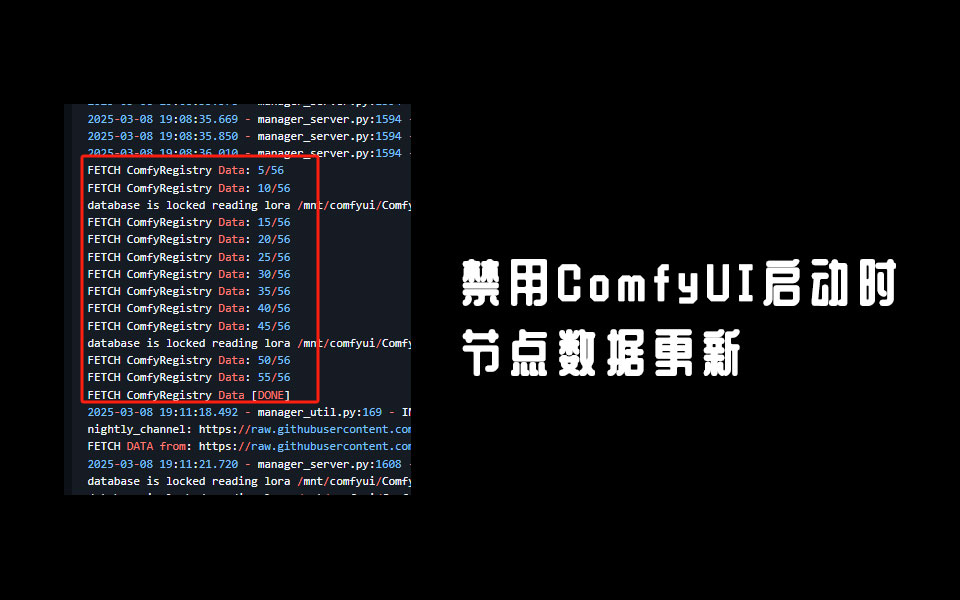

Comfyui插件

如果使用了整合包,则不需要单独安装插件

- WanMoeKSampler:Wan 2.2 MoE 自动切换采样器ComfyUI-WanMoeKSampler-数字折叠

- WanBlockswap:Wan2.2官方流内存交换插件ComfyUI-wanBlockswap-数字折叠

- KJnodes:ComfyUI-KJNodes 一个可以让工作流中各节点无线连接的ComfyUI节点集-数字折叠

- ComfyUI-VideoHelperSuite: ComfyUI-VideoHelperSuite视频助手插件-数字折叠

- impact-Pack:ComfyUI-Impact-Pack图像检测增强插件(函检测模型)-数字折叠

- was-node-suite-comfyui:was-node-suite-comfyui图像数据处理插件-数字折叠

- ComfyUI_essentials:图像处理插件ComfyUI_essentials-数字折叠

- GGUF:ComfyUI-GGUF插件下载-数字折叠

模型下载

下载前先检查下存放路径,避免重复下载

Wan2.2图生视频14B量化GGUF模型-数字折叠(所有模型都要下载到相应位置)

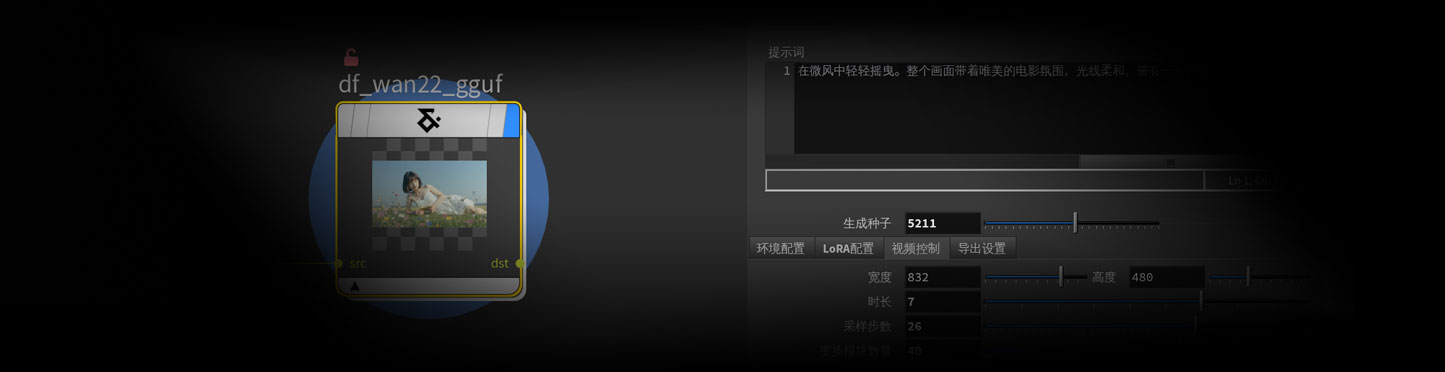

参数说明

- 生成视频:点击将会执行控制图像生成视频功能。

- 启动AI:点击即可启动ComfyUI(需要 提前设置好Comfyui的路径)。

- 查看结果:执行完毕之后可以点击该按钮将生成的视频复制到你设置的保存路径里面,并且自动打开该文件夹。

- 提示词:视频生成的提示词,支持中文。提示词参考文档:通义万相AI生视频—使用指南 · 钉钉文档

- 生成种子:控制视频生成时的随机种子

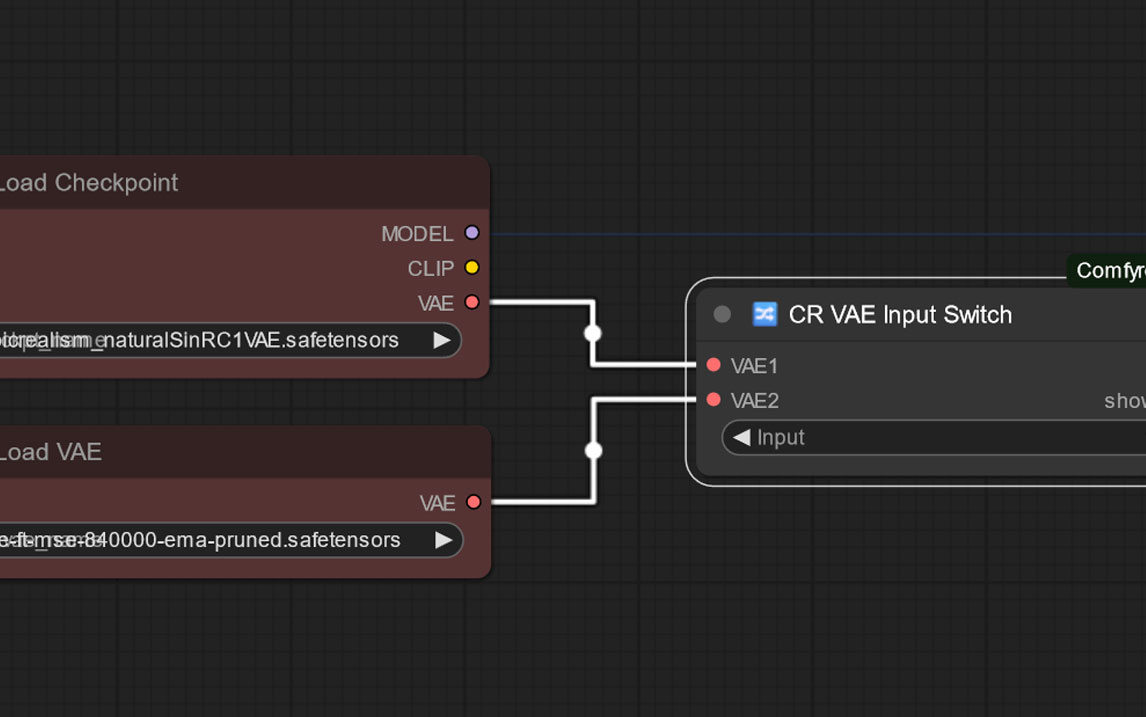

环境配置

- Comfy路径:你的ComfyUI安装路径,启动脚本所在的文件夹。

- 服务器地址:默认填写127.0.0.1:8188

- High模型:选择Wan2.2-I2V-A14B-HighNoise-Q6_K.gguf(低显存下载Q4版本)

- Low模型:选择Wan2.2-I2V-A14B-LowNoise-Q6_K.gguf(低显存下载Q4版本)

- vae模型:选择comfy-wan_2.1_vae.safetensors

- text_encoders模型:选择umt5_xxl_fp8_e4m3fn_scaled.safetensors

LoRA配置

- Height加速:选择 Wan21_I2V_14B_lightx2v_cfg_step_distill_lora_rank64.safetensors

- Height加速强度:控制高采样时的加速强度,最大值是1,值越小动态越丰富,需要提高相应的采样步数。

- low加速:选择 low_noise_model.safetensors

- Low加速强度:建议保持默认1

视频控制

- 宽度/高度:生成视频的分辨率,宽图选择832*480,长图选择480*832(由于内部裁切原因,最终输出镜头分辨率会有些偏差)

- 时长:视频生成的时间,单位为秒。

- 采样步数:视频生成时的采样步数,测试视频建议8-12步,最终生成建议15-25步

- 变换模块数量:将一些GPU显存交换给CPU,指定将多少个 Transformer 模块从默认设备(如 GPU)交换到其他设备(如 CPU)处理,以优化显存或性能。最大值取决于模型结构,如 14B 模型最多有 40 个模块。如果你的GPU显存小内存大的话可以将这个数值给高。

导出设置

- 文件夹/前缀:设置输出视频时在Comfyui中的OUT文件夹内的存储文件夹和视频名。

- 保存路径:该路径是点击查看结果时将生成的视频复制的路径。

- 清理原始视频:点击该按钮将会删除OUT文件夹内容的生成视频的文件夹内的所有内容。

- 调试:点击后会把当前的设置保存为一个json文件,方便直接拖入ComfyUI中生成,保存路径和视频保存路径一致。

使用方法

1.将hda下载下来,通过Houdini菜单上的Assets-Install Asset Library进行安装,或者直接放到C:\Users\yourname\Documents\houdini20.5\otls文件夹内Houdini会自动识别。

2.在houdini项目中新建一个copnet节点,进入该节点搜索创建df_wan22_gguf节点就可以开启该工作流

3.需要通过file或者其他节点加载一张图片,将这个图片连接给该工作流。

版权说明

本 HDA 工具版权归 数字折叠 所有。

禁止任何形式的分享、转售或二次分发。

数字折叠 仅为在本网站购买或获得本工具使用权限的用户,提供使用答疑与远程指导服务。

本 HDA 工具中所使用的 AI 大模型及相关 LoRA 均为原作者个人版权,版权与知识产权归原作者所有。

任何未经授权的使用、传播或商业行为,均视为侵权,数字折叠保留依法追究责任的权利。

禁止任何形式的分享、转售或二次分发。

数字折叠 仅为在本网站购买或获得本工具使用权限的用户,提供使用答疑与远程指导服务。

本 HDA 工具中所使用的 AI 大模型及相关 LoRA 均为原作者个人版权,版权与知识产权归原作者所有。

任何未经授权的使用、传播或商业行为,均视为侵权,数字折叠保留依法追究责任的权利。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容