模型介绍

阿里推出 Wan2.2,这是对Wan2.1基础视频模型的一次重大升级。在 Wan2.2 中,专注于引入以下创新:

- ? 有效的 MoE 架构:Wan2.2 将混合专家(MoE)架构引入视频扩散模型。通过使用专门的强大专家模型跨时间步分离去噪过程,这扩大了整体模型容量,同时保持相同的计算成本。

- ? 电影级美学:Wan2.2 整合了精心策划的美学数据,包括详细的照明、构图、对比度、色调等标签。这使得可以更精确和可控地生成电影风格,并便于创建具有可定制美学偏好的视频。

- ? 复杂的运动生成:与 Wan2.1 相比,Wan2.2 在显著更多的数据上进行训练,图像增加了 +65.6%,视频增加了 +83.2%。这一扩展显著增强了模型在多个维度上的泛化能力,如运动、语义和美学,在所有开源和闭源模型中达到了顶尖性能。

- ? 高效的高清晰度混合 TI2V:Wan2.2 开源了一个使用我们的先进 Wan2.2-VAE 构建的 5B 模型,实现了 16×16×4 的压缩比。该模型支持 720P 分辨率、24fps 的文本到视频和图像到视频生成,并且可以在消费级显卡如 4090 上运行。它是目前可用的最快的 720P@24fps 模型之一,能够同时服务于工业和学术领域。

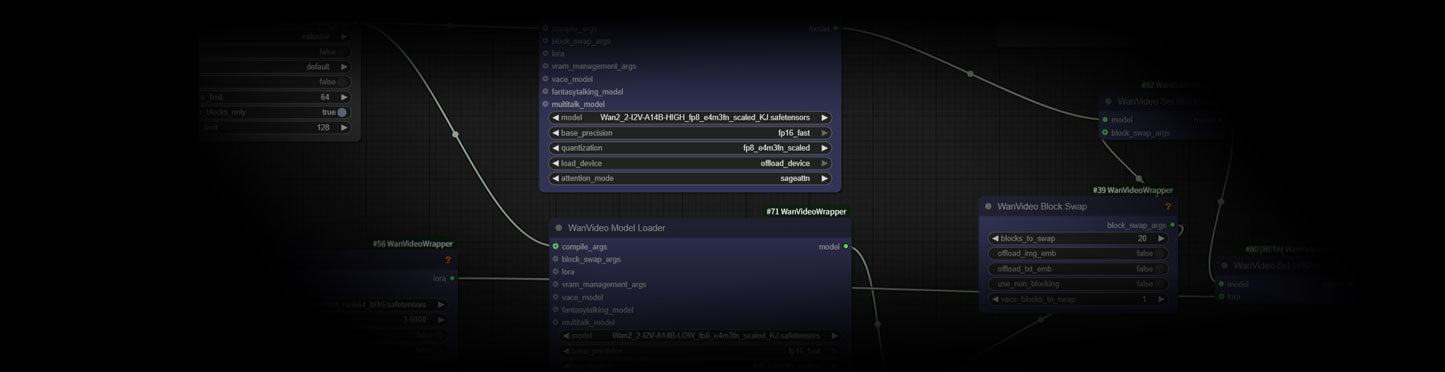

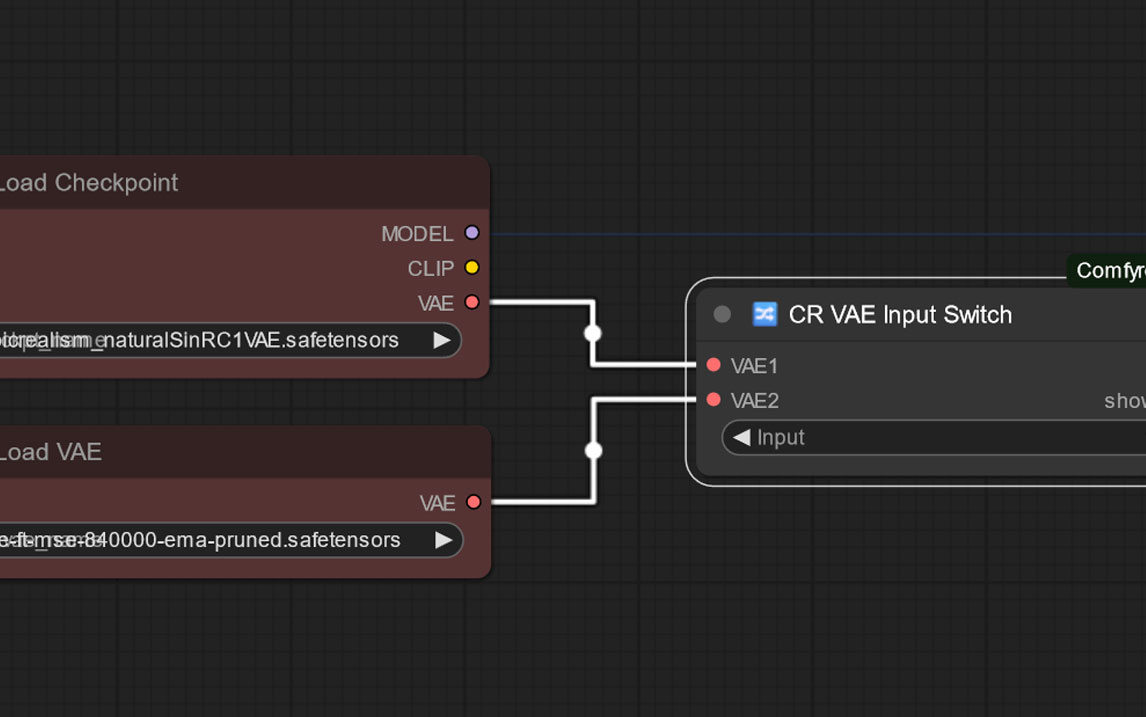

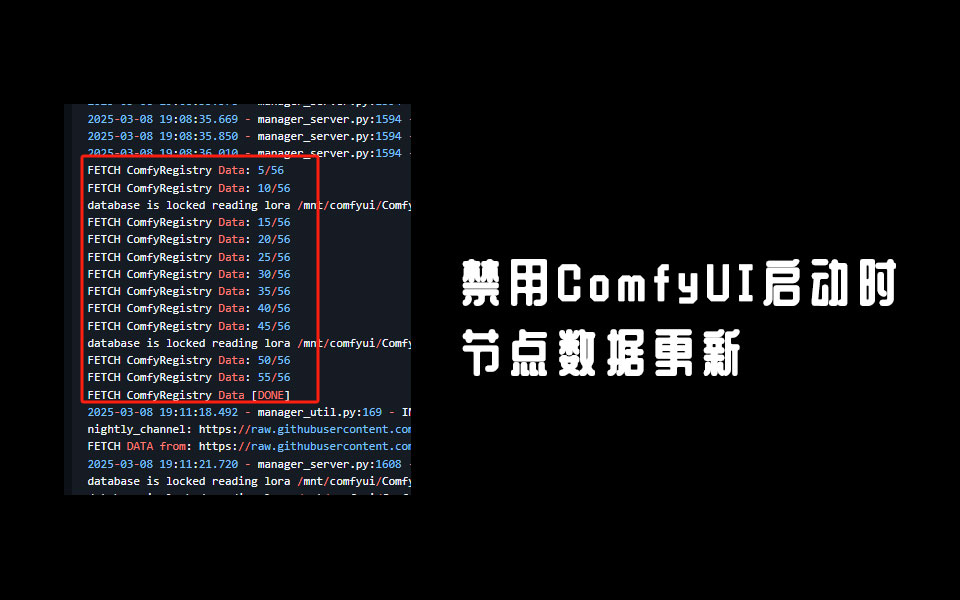

由于官方的模型较大,我们本次先给大家提供的是适配于Kijai工作流的模型,主要是High与Low两个文生视频模型以及T5和VAE模型的百度网盘下载链接。

安装位置

- 图生视频模型放到models\diffusion_models文件夹内(默认下载的是适配40 50系列显卡,如果是30系列显卡请下载单独的30显卡文件夹里的两个模型)

- VAE模型放到models\vae文件夹内

- text_encoders模型放到models\text_encoders文件夹内

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容